In der Bewertung von Karl Lauterbachs Politikvorschlägen ist es notwendig, sich der Methodik der evidenzbasierten Gesundheitspolitik zu versichern. Das Konzept der evidenzbasierten Gesundheitspolitik ist zwar viel „besungen“, aber grundsätzlich ziemlich unbestimmt. In der Regel wird eine Analogie gezogen zur evidenzbasierten Medizin oder gelegentlich zur Evidenbasierten Public-Health-Politik, die jedoch insofern keine guten Vergleichsmaßstäbe sind, als es sich in beiden Fällen um hochkomplexe und zeitaufwändige Verfahren bzw. hierarchisierte Sammlungen von prospekt- und retrospektiven Methoden der Bewertung der vorliegenden wissenschaftlichen Evidenz handelt, die – so augenscheinlich der Eindruck in hektischen Corona-Zeiten – nach den Kochbüchern angewandt viel zu lange dauern würde. Nicht zuletzt in den bereits kritisch beurteilten Talkshows (was für ein entlarvender Name!) – jüngst in Anne Wills Runde vom 12.12.2021 – wird ja stets davon gesprochen, dass „wir keine Zeit“ haben – von der Moderatorin selbst…eigentlich ein Eingeständnis, dass es mit der Evidenzbasierung der Politik nicht so weit her sein kann (zu Fragen der kommenden Impflicht und ihrer – fragwürdigen – Begründung sei auf die „nächste Folge“ dieser Staffel verwiesen).

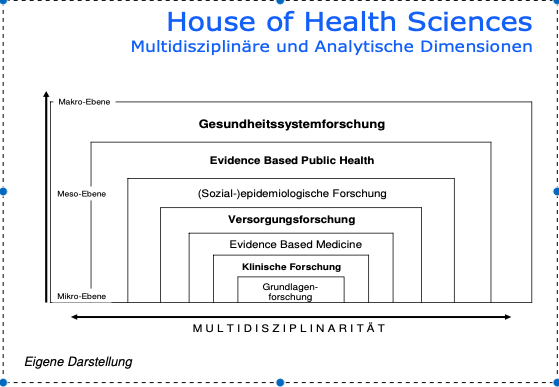

Da es hier nicht darum gehen kann, einen Ersatz für die sinnvolle Lektüre von einführenden Büchern in die Thematiken der evidenbasierten Medizin bzw. Public Health Forschung zu liefern, sollen nur exemplarisch bestimmte Aspekte herausgestrichen werden, die in der Corona-Pandemie von Bedeutung sind. Zunächst ist einführend festzustellen, dass in Medizin und Gesundheitswissenschaften sehr unterschiedliche Forschungsprogramme – um einen Begriff des Wissenschaftstheoretiker Imre Lakatos zu nutzen – bestehen, um die Gesundheits- und Krankenversorgung effektiver (und vielleicht auch effzienter, das ist aber mehr was für Gesundheitsökonom:innen) zu gestalten. In einer mittlerweile bereits in die Jahre gekommen Publikation habe ich mal vom „Haus der Gesundheitswissenschaften“ gesprochen, um die beteiligten Forschungsprogramme miteinander in Beziehung zu setzen (siehe Abbildung unten).

Die evidenzbasiete Medizin bezieht sich demnach vor allem auf die Bewertung klinischer Verfahren, die in der klinischen Forschung an Individuen entwickelt wurden, wohingegen sowohl die epidemiologische Forschung als auch die Evidence based Public Health einen stärkeren Bezug zur Gesamtbevölkerung in einer Gesellschaft bzw. einem Staat haben und noch stärker auf die Behandlung von Krankheiten insgesamt oder aber von bevölkerungsweiten Maßnahmen fokussieren. Während die Gesundheitssystemforschung auf ganze Versorgungssysteme schaut und diese in ihre Effektivität und Effizienz zu bewerten versucht, liegt die (medizin/soziologisch/e) Versorgungsforschung in der Mitte. Versorgungsforschung schaut auf die Praxis der Anwendung von medizinischen Technologien und klinischen Techniken im realen Setting und weniger auf deren grundsätzliche Wirksamkeit (unter experimentellen Bedinungen).

In der Praxis jedoch sind diese – hier sehr schmatisch abgegrenzten – Forschungsprogramme keineswegs völlig getrennt. So ist beispielsweise der Virologe Prof. Dr. Christian Drosten in diesem Bild grundsätzlich eher in der Grundlagenforschung anzusiedeln (Virologie), wird aber paradoxerweise durch Prozesse der Politizierung der Wissenschaften dann (mit eifriger Unterstützung des Robert-Koch-Instituts und des Bundesgesundheitsministeriums) zum epidemiologischen Experten, der er seiner Zunft nach aber eigenglich nicht ist. Die Virologie beschäftigt sich mit der Verbreitung von Viren und der Rolle dieser Entitäten für die Krankenheitsgesense, nicht jedoch für die Dynamiken des Ausbruchs. Lediglich in der Corona-Pandemie ergibt sich das Novum, dass molekulardiagnostische Verfahren (RT-PCR-Test) zur Identifzierung von epidemiologischen Kategorien (Inzidenz) genutzt werden, obwohl sie hierfür nur bedingt nützlich sind, wie schon immer die US-amerikanischen Centers for Disease Control und Prevention (CDC) in Atlanta herausgestrichen haben. Ein Diagnosetool ist es von seiner Genese her also nicht; und auch die Messung der „Melderaten“ erfasst nicht das epidemiologische Geschehen. Doch das sehen natürlich Virenepidemiologen (und ihre politisch-medialen Adepten) ganz anders. Epidemiologe ist halt keine rechtlich geschützte Berufsgruppe. In der Regel handelt es sich bei diesen Personen um Mediziner:innen, Soziolg:innen oder Gesundheitwissenschaftler:innen mit Schwerpunkt auf quantitativen Forschungsstrategien.

Methodik ist bei allen weitgehend gleich: Quantifizieren

Bei aller Differenzierung der Forschungsprogramme fällt daher sofort ins Auge, dass die diversen Hand- und Lehrbücher zur Thematik weitgehend ähnliche, wenn nicht sogar identische methodologische Standards hervorheben. Die berühmte „Evidendenzpyramide“ von Forschungsstrategien, die zu einer hohen Aussagequalität und einem hohen Objektivitätsgehalt führen, ist steil, aber überall weitgehend gleich. Von dem Anspruch auf „Wahrheit“ ist man – im Gegensatz zur Politik und den politizierten Wissenschaftler:innen im öffentlichen Diskurs – in der zugrundeliegenden wissenschaftlichen Forschungspraxis und wissenschaftstheoretischen Reflexion im Grund abgekommen. Eine Studie allein sagt gar nichts aus. Bringen Sie das mal Menschen bei, die in jeder Studie ihre „Annahmen“ bzw. „Ängste“ oder auch „Strategien“ bestätigt sehen. Eine solche Herangehensweise mag dem Weber’schen Anspruch auf Politik als der „Kunst des Möglichen“ genügen, wissenschaftliche Evidenz, die ja in ihrem Begriff gerade jenen oben genannten Skeptizismus auf „Wahrheit“ beinhaltet, ist eine solche recht hemdsärmelige Nutzung von Ergebnissen (einzelner!) wissenschaftlicher Studien beileibe nicht. Wenn Sie also jemanden reden hören: es gibt eine „neue Studie“ zu XYZ, dann schalten Sie am Besten Ihren skeptischen Automat und Ihre Warnlichtlampen ein. Das gibt es nicht.

Evidenzbasierung heißt folglich nicht: „Wahrheit“. Doch in der Politik wird gelegentlich dieser Begriff so genutzt, als würde Evidenzbasierung identisch sein, was man im Deutschen „evident“ bezeichnet, also die Bewertung: ist doch klar, dass das so ist. Bewiesen. Punkt. Das ist jedoch ein großes Missverständnis. Evidenzbasiert und evident sind zwei komplett unterschiedliche Begriffe. Wenn ich morgens aus meinem Bett aufstehe, mag es evident sein, dass ich die Füße auf den Boden setze. Evidenzbasiert ist es dadurch noch lange nicht. Evident ist also im Deutschen ein Wort für „offensichtlich“; dagegen jedoch ist die evidenzbasierte Medizin gerade angetreten. Kalauermäßig wird in ihre Geschichte damit erzählt, dass sie von der eminenzbasierten zur evidenzbasierten Medizin fortgeschritten ist. Als eminenzbasierte Medizin hat man die Medizin bezeichnet, die bis weit in die 1970er Jahre sich von den „Koryphäen“ einzelner Universitätsprofessor:innen erzählen lassen wollte, was der „Stand“ ihrer Wissenschaft sei. Dass diese eminenzbasierte Medizin viel Unfug angerichtet hat, muss hier nicht erwähnt werden, sondern ist von der Gesundheits- und Umweltbewegung und ihres „Forschungsarms“ der kritischen Gesundheitswissenschaft seit den 1970er Jahren oft kritisiert worden. Anregend zu lesen ist hierbei immer noch Ivan Illichs Klassiker „Medikalisierung. Über die Nemesis der modernen Medizin“. Alterantiv auch das altehrwürdige Jahrbuch für kritische Medizin (und Gesundheitswissenschaft, wie es jetzt heißt).

Evidenzbasierung heißt folglich in einem ersten Näherungsschritt, zur Beantwortung einer praktisch relevanten klinischen oder auch epidemiologischen Frage die verfügbare Studienlage (weltweit zumeist) auf die Ergebnisse zu befragen und zu bewerten. Und sich eben nicht auf die Eminenzhörigkeit der Menschen zu verlassen, die im weißen Kittel der Mediziner:innen immer noch den „Gott in Weiß“ erkennen möchten wollen. In diesem Anspruch liegt dann aber auch eine Gefahr. Denn er verleitet dann dazu, dass eine „neue Studie“ – gut promotet – den gesundheitspolitischen Diskurs mehr zu bestimmen in der Lage scheint, als andere. Der Bezug zu einer Studie ist aber – wie bereits erwähnt – vieles, aber keine Praxis evidenbasierter Medizin. Nun gibt es aber – wie in der ersten Folge des „Pilotfilms“ zu „Lauterbach-Watch“ erwähnt – in jeder wissenschaftlichen Disziplin, so eben auch in Medizin, Virologie und Epidemiologie, Zitationszirkel, die – ähnlich den berühtmen Filterblasen der sozialen Medien – nur das wahrnehmen, was sie als anerkannten Kern ihrer wissenschaftlichen Weltanschauung und -praxis erwählt haben. Genauso hat der Wissenschaftstheoretiker Imre Lakatos im Übrigen den Kern von wissenschaftlichen Forschungsprogrammen bestimmt, ebenso wie der (ebenfalls im ersten Teil der Pilotfolge zitierte) US-amerikanischen Politikwissenschaftler Paul A. Sabatier seine Advocacy-Koalitionen konstruiert hat (in direktem Bezug zu Imre Lakatos übrigens). Aus diesen gefilterten Forschungsprogrammen erwächst dann die Gefahr, dass häretische oder völlig konträre Forschungsprogramme gar nicht wahrgenommenn oder – wenn doch – dann als „völlig haltlos“ bewertet und „verteufelt“ werden. Und zwar zumeist allein deswegen, dass diese die genannten Wertüberzeugungen und wissenschaftlichen Prämissen des zu verteidigenden Forschungsprogramms gar nicht teilen. Wenn in solchen Konstellationen dann noch Politik, also der Kampf um Diskursmacht und Deutungshoheit, dazukommen, dann erlischt der (herrrschaftsfreie) Diskurs, bevor er überhaupt beginnen konnte. Die Kommunikation – um Niklas Luhmann zu paraphrasieren – bricht nicht zusammen, sondern beginnt erst gar nicht, weil sie nicht „anschlussfähig“ ist.

In diesen Momenten kommen zumeist Befürworter:innen demokratischer Deliberation ins Spiel, die dann fordern, man müsse, unterschiedliche Stimmen an den Tisch bringen. Doch das ist zwar gut gemeint, aber ebenso naiv oder zumindest „herausfordernd“. Forschungsprogramme, die nicht zueinander passen, kommunizieren auch nicht. Der Wissenschaftstheoretiker Thomas Kuhn nannte das die Inkommensurabilität von Paradigmen, die Forschungsfragen und Forschungspraxen anleiten – auch in der Medizin. Nun lässt sich dieses Patt zwar nicht komplett auflösen, aber doch etwas zum Tanzen bringen, wenn der Begriff der evidenzbasierten Medizin etwas genauer ausbuchstabiert wird, als es zumeist in der politischen Öffentlichkeit, aber auch der interessierten Fachöffentlichkeit erfolgt. Nötig ist also, sich den methodischen Instrumenten der Evidenzbasierung genauer zuzuwenden. Und dass sind die Bestandteile dessen, was oben bereits als „Evidenzpyramide“ bezeichnet wurde. Trotz aller Differenzen im Einzelnen und der Corona-Pandemie im Besonderen sind sich alle praktizierenden Gesundheitswissenschaftler:innen einig, dass es bestimmte Evidenzstufen gibt, die eine einzelne Studie erfüllen kann und die methodologisch etwas über ihre Aussagekraft aussagt. Die renommierte Medizinerin und Gesundheitswissenschaftlerin Trisha Greenhalgh (2003) hat in ihrem einführenden Buch zur „Evidence-based Medicine“ (auf deutsch im Hans Huber Verlag, Bern, erschienen) folgende Studientypen gelistet, die – absteigend – die höchste Evidenz (im Sinne von interner Validität) über die untersuchte Thematik aufweisen: (i) Systematische Reviews und Meta-Analysen, (ii) Randomisiert-kontrollierte Studien mit definitiven Ergebnissen, (iii) randomisiert-kontrollierte Studien mit nicht-definitiven Ergebnissen (was der Unterschied zwischen i) und ii) ist, wird noch erklärt), (iv) Kohorten-Studien, (v) Fall-Kontroll-Studien, (vi) Querschnittstudien und (vii) Fallberichten. Auch in epidemiologischen und biomedizinischen Statistikbüchern werden dieselben Studientypen (und auch in der gleichen Hierarchie) genannt, wie sie die britische Mediziner:in aufgelistet hat.

Der Teufel liegt – wieder einmal – leider im Detail

Prima, könnte man nun denken. Dann schaut man eben auf die Studien darauf, die zu einem Thema – etwa Corona und Masken – veröffentlicht wurden und voilá zaubert die „Evidenz“ aus dem Hut. Schön wär’s. Wobei der Grundgedanke natürlich nicht falsch ist. Denn in der politischen Öffentlichkeit wird – ich sprach bereits davon – gern zur Stützung eines (jeden!) Arguments auf die eine oder andere Studie verwiesen, ohne auch nur im Ansatz, diese methodenkritisch wahrzunehmen oder – Gott behüte! – vergleichend zu lesen. Das ist grundsätzlich kein Problem der Wissenschaft, sondern der Politik und, so ließe sich anfügen, der politisierten Wissenschaftler. Damit will ich nicht einer „wertfreien“ und „abgehobenen“ Wissenschaft das Wort reden. Im Gegenteil, sind politisierte Wissenschaftler solche, die sich für einen kurzen Moment der Macht vor den Karren der Politiker:innen spannen lassen. Wie der langjährige Vorsitzende des Sachverständigenrates zur Konzertierten Aktion im Gesundheitswesen, Prof. Dr. Friedrich W. Schwartz, zurecht sagte, lässt sich ernsthafte wissenschaftliche Tätigkeit nicht mit einem politischen Mandat verbinden. Insofern hat der neue Bundesgesundheitsminister ein überaus gefährliches Experiment begonnen, denn er behauptet, genau dies tun zu können (oder gar zu müssen). Doch die als Ehtik der Politikberatung gemeinte Maxime von Prof. Dr. Schwartz hat in einer zunehmend politisierten und ökonomisierten Öffentlichkeit und Wissenschaft kaum noch eine Chance, ernsthaft verfolgt zu werden. Zu diesen Auswüchsen haben die Soziologen Peter Weingart und Richard Münch bereits alles Nötige gesagt.

Doch die Erarbeitung einer Evidenzgrundlage für politische Entscheidungen benötigt Zeit und die Lektüre mehrerer Studien, auch außerhalb der politizierten Filterblase. Etwas, was in Zeit von Corona und dem Selbstverständnis des neuen Chefs im Haus des Bundesgesundheitsministeriums für (zu) knapp gehalten wird. Nun gibt es eine hilfreiche Praxis der wissenschaftlichen Zunft auf diesem Feld, die verlangt, dass Studienergebnisse von methodisch möglichst hochwertigen Studien, die oft mit einem Wust von Tabellen, Diagrammen und statistischen Modellen daherkommen, zu Beginn in ihrem Kern zusammengefasst werden: (A) Fragstellung, (B) Methodik der Beantwortung der Frage und (C) Ergebnisse der Studie. Diese standardisierte Form der Zusammenfassung der Studien (in praktisch allen relevanten Fachjournalen) soll die Selektion von Studien für die höchste Evidenzstufe, die systematischen Reviews und Meta-Analysen, erleichtern. Die Form verleitet aber leider auch dazu, sich in der (zeitsparenden) Konsumtion von zahllosen Studien mittels der Lektüre eben dieser als Abstract bezeichnenden Zusammenfassungen einen zwar guten Überblick, aber letztlich wankenden Evidenzboden für die Beantwortung relevanter Fragestellungen anzueigen. Warum schwankend? Nun, ganz einfach, nämlich dadurch, dass in dieser Art „Bulimie-Lektüre“ von Studien strukturell die methodischen Beschränkungen und damit die Verallgemeinerbarkeit der Studienergebnisse (externe Validität) übergangen werden, indem weder der Aufbau der Studie nachvollzogen noch die von Wissenschaftler:innen geforderte reflexive Diskussion der Einschränkungen der Aussagekraft von Studien berücksichtigt werden. Denn der letzte und eigentlich wichtigste Teil von Studien(ergebnissen) ist die kritische Diskussion der Ergebniss im Hinblick auf die geplante und letztlich umgesetzte Forschungspraxis. Dass dies durchaus ein kritischer Punkt sein kann, habe ich anhand einer (Talk-Show-) Behauptung von Karl Lauterbach, Covid-19-Infizierte (selbst ohne Symptome) würden einen starken Verlust ihrer Intelligenz erleiden, zu belegen versucht (Zusammenfassung bei Timecode: 28:15 min).

Es dürfte keinen überraschen, wenn ich behaupte, dass eine solche kritische Diskussion von Forschungsergebnissen in der politischen Öffentlichkeit nicht stattfindet. Spätestens beim p-Wert oder dem Konfidenzintervall winken die letzten Zuhörer oder Zuschauer ab. Von daher lässt sich konstatieren, dass es in der politischen Öffentlichkeit – und nicht nur beim Thema Corona, sondern auch bei Thema Klimawandel – eine merkwürdige Renaissance eines recht naiven Wissenschaftsglauben gibt (wenn auch beim Klimawandel eher in Richtung auf den Glauben an „technische Lösungen“). Dass wissenschaftliche Laien darauf hoffen (müssen), dass (oftmals) selbst erklärte, aber auch reputierlich ausgewiesene, also mit Professur und internationaler Reputation ausgetattete, Expert:innen es besser wissen, dabei aber einem fröhlichen Positivismus frönen, der trotz offenkundigem Hin- und Hereiern bei der Präsentation von Überlegungen und (vermeintlich sicheren) Forschungsergebnissen Schwierigkeiten hat, festen Boden zu erreichen, kann nicht überraschen. Worauf sollen die Laien sonst hoffen, wenn der Politik selbst nicht mehr geglaubt wird? Wenn jedoch die Expert:innen im Zeitalter des Neoliberalismus zu Agenten der „Sachzwanglogik“ (Anthony Giddens sprach noch von einer gewissen Ambivalenz dieser Expertensysteme) werden, sich also als Akteure der „Entbettungsmechanismen“ (Elmar Altvater und Birgit Mahnkopf, Grenzen der Globalisierung) betätigen, wird es wichtig, dass die „Subpolitik“ (Ulrich Beck) sich der Praxis der Wissenschaftlichkeit selbst versichert, um den „grauen Männern“ (und zunehmend auch Frauen) entgegentreten zu können. Denn die ökonomisierte und politizierte Wissenschaft hat ihre einst rührige, mittlerweile nur noch als geschäftstüchtig zu bezeichnende Objektivität weitgehend verloren. Zwar disqualifiziert eine Auftragsstudie bzw. eine Studie mit Interessenkonflikten keineswegs automatisch die Forschungsergebnisse; es ist allerdings naiv, solche Interessenkonflikte als „gelöst“ zu bewerten, wenn sie (nur bloß) kundig gemacht werden. Dazu gab es schon zu viele gezinkte Studien und nicht hilfreiche Ergebnisse, deren Veröffentlichung der Auftraggeber trotzt Offenlegung von „Interessenskonflikten“ untersagt hat (und die nur durch Whistleblower:innen bekannt wurden).

Die Grundidee der Studientypen: Versuch eines ersten Aufrisses

An erster Stelle der Evidenzhierarchie (EVIH) stehen systematische Reviews bzw. Meta-Analysen. Dabei handelt es sich um Methoden, die die vorliegenden Forschungsergebnisse zusammenfassen. Im eigentlichen Sinne sind sie keine Forschungsmethoden, da sie keine eigenen Primärdaten erschaffen, sondern diese von anderen Studien hervorgebrachten Studienergebnisse (=Primärdaten) auf ihre Qualität und Aussagengehalt zusammenfassen und bewerten. Sie gelten – wenn korrekt durchgeführt – als die höchste Evidenzform, sind aber extrem aufwändige und langwierige Formen der Evidenzsicherung. In Deutschland arbeitet das Institut für Qualität und Wirtschaftlichkeit (IQWiG) mit dieser Methode, die jeweils auf die entsprechenden thematischen Komplexe und Fragestellungen angepasst ist. Merkwürdigerweise, da hat Wolfgang Wodarg völlig recht, spielt es bei der Bewertung von Covid-19-Studien überhaupt keine Rolle. Allein das ist schon mehr als seltsam. Die Angebote seines Präsidenten, Prof. Dr. Johannes Windeler, wurden von der Politik regelmäßig abgelehnt. Warum das BMG auf das RKI vertraut, liegt doppelt nahe: (i) ist es das Institut, welches nach dem Infektionssschutzgesetz zuständig ist und (ii) ist es vom Ministerium weisungsabhängig. Das kam jetzt auch allen Vertretern der hofberichtlichen Journaille zutage, weil dessen Unabhängigkeit von dem Ministerium als Ziel in der Koalitionsvereinbarung der neuen Regierung steht (SPD/Bündnis90/Die Grünen/FDP 2021: 83; Zeile 2758; „Das RKI soll in seiner wissenschaftlichen Arbeit weisungsungebunden sein“).

Meta-Studien (Reviews und Analysen) versuchen also die verfügbare Evidenz zusammenzufassen; egal, welches Ergebnis vorliegt. Während systematische Reviews einen Überblick über Primärdaten (von verschiedenen Studien) erstellen,

– der explizite Angaben an Zielen, Materialien und Methoden enthält und

– der nach einer expliziten und reproduzierbaren Methodik erstellt wurde“,

Greenhalgh (2003): Einführung in die Evidence-based Medicine. Kritische Beurteilung klinischer Studien als Basis einer rationalen Medizin. 2., vollständig überarbeitete Auflage, Bern et al.: Hans Huber, S. 153.

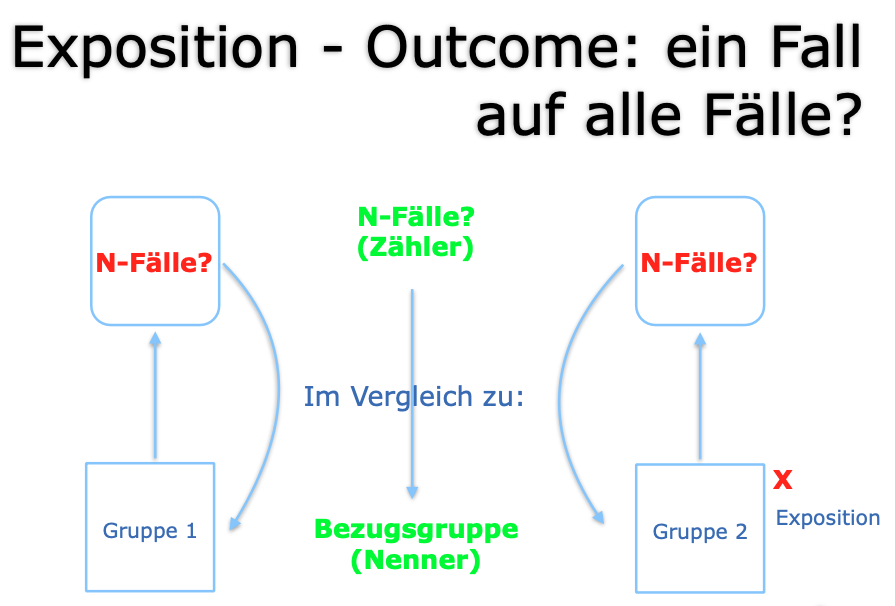

werden in Meta-Analysen die „statistische Synthese der nummerischen Ergebnisse mehrerer Studien, die alle die gleiche Frage untersuchen“ (ebd.: 161), dargestellt. Wie aber nun, so die Frage, werden diese Primärdaten erschaffen? Nun, mittels der Studientypen II-VI (siehe oben). In die Details zu gehen, entbehrt hier jeder Grundlage und kann nicht ernsthaft erwartet werden (siehe dazu: das Buch von Greenhalgh, aber auch Einführungsbuch von Fletcher/Fletcher/Fletcher [2019] in die Klinische Epidemiologie oder – populärer – die Bücher von Ben Goldacre [Die Wissenschaftslüge, Ffm, Fischer 2010 oder Bad Pharma 2013]; lesenswert ist auch die Einführung in die Epidemiologie in der bekannten Dummies-Reihe von drei Bielefelder Epidemiologen). Nichtsdestotrotz will ich versuchen, propädeutisch gewissermaßen, die Grundidee dieser Studientpyen (die oft gemischt und weiterentwickelt werden) zu vermitteln. Das Basisargument ist relativ einfach und ziemlich alt, geht es doch zurück auf eine zentrale Denkfigur des britischen Empirismus; sie wird John Stuart Mill zugeschrieben und ist als basale Vergleichsmethode in die Wissenschaftstheorie eingegangen. Die Grundidee liegt der Klinischen Epidemiologie ebenso zugrunde wie der Evidenbasierten Medizin oder der Infektions- oder Sozialepidemiologie. Sie lässt sich am einfachsten mit folgender Abbildung veranschaulichen (siehe Abbildung 2; eigene Darstellung).

In der Epidemiologie und klinischen Forschung sollen Kausalitäten hergestellt werden, also die Suche nach Ursachen und Begründungen der Zusammenhänge von (wenigstens) zwei Variablen: hier als Exposition und Outcome bezeichnet. Die Exposition könnte auch als Explanans oder als unabhängige Variabe betrachtet werden, also etwas auf das etwas folgt, nämlich der Outcome. Dieser ist das, was erklärt werden soll (= lat. „Explanandum“) bzw. statistisch betrachtet ist er (der Outcome) abhängig von der Exposition, ist also eine abhängige Variabe. Wenn eine Kausalität vorliegt, gilt, dass sich die Häufigkeit des Outcomes in einer besonderen, auffälligen (besonders starken etwa), nicht zufälligen, Weise mit dem Auftreten (der Häufigkeit) der Exposition verändert. D.h. es werden immer zwei Gruppen miteinander verglichen, die sich nur darin unterscheiden, ob eine Exposition, ein Faktor vorliegt, der als Explanans vermutet wird. Treten dann die hypothetisch vermuteten Fälle in der exponierten Gruppe (Gruppe mit Exposition) häufiger auf und lässt sich statistisch ausschließen, dass dieses Ergebnis in der Studie zufällig ist, dann ist zumindest in dieser Studie ein statistisch signifikanter (= nicht zufälliger) Zusammenhang zwischen Exposition und Outcome (N-Fälle) belegt. Schön. Und dann?

Eine Kausalität ist das dann aber noch nicht. Erst wenn dieser Zusammenhang in verschiedenen Zeiten, bei verschiedenen (Studien-)Populationen immer wieder auftritt, mit der „Dosis“ der Expostion variiert und vor allem wenn dieser Zusammenhang verschwindet, sobald die Exposition weg ist (d.h. dann tritt auch das Outcome nicht auf), kann die Vermutung gewagt werden, dass der bislang nur mehrfach replizierte statistisch signifikante Zusammenhang kausal sein könnte. Eines fehlt noch: in diesen in der Epidemiologie nach einem bekannten Epidemiologen als „Bradford-Hill-Kriterien“ bekannten Merkmalen kausaler Verknüpfungen muss auch der vermutete Kausalfaktor zeitlich vor dem verursachten Effekt (Outcome) liegen. Die Verschränkung von Ursache und Wirkung – wie in Systemtheorie und Chaostheorie angedacht – ist also in dem hier vorliegenden (linearen) Wissenschaftsverständnis nicht zulässig. Wenn aber dann noch mehrere Faktoren zusammen ein Ergebnis hervorbringen, wenn also multifaktoriell verursachte Phänomene vorliegen, von denen es in Gesundheitswissenschaften und Medizin nur so wimmelt, wird alles deutlich schwieriger und die Ergebnisse, mithin die Evidenzstärke schwächelt. Dann werden multivariate statistische Verfahren angewandt oder noch komplexer gleich ganze Computermodelle erarbeitet. Die grundsätzliche Idee des Zwei-Gruppen-Vergleiches verschwindet dann nicht, aber die „Erklärung“ der Ergebnisse („Ursachenfindung“) wird deutlich komplizierter.

Eine Sache sollte noch ganz zentral hervorgehoben werden, bevor in der nächsten Folge dann die verschiedenen Studientypen durchdekliniert werden: die beiden Gruppen (bei einer randomisiert-klinischen Studie: Interventions- und Kontrollarm) dürfen sich wirklich nicht unterscheiden. D.h. die Studienpopulation im Kontrollarm müsste idealerweise ein „Klon“ der Studienpopulation des Interventionsarms (also der einzelnen Studienteilnehmer) darstellen, nur mit dem Unterschied, dass in dieser auch eine vermuteter Faktor vorliegt, der in jener nicht zu finden ist. Dieses Klonen ist natürlich nicht möglich, und daher ist die „natürliche“ Unterschiedlichkeit der beiden Gruppen ein Problem. Denn sie wird zur Quelle von allerlei „Störfaktoren“, die das Ergebnis, den errechten Zusammenhang von Exposition und Outcome verzerren können: Bias genannt. Von diesen kaum zu vermeidenden Bias handelt dann auch meistens die kritische Selbstreflexion der Studienautoren im Diskussionsteil einer (guten) Studie. Was das genau heißt werden wir in den nächsten Folgen dieser Staffel 1 („Lauterbach-Watch“) uns anhand der oben genannten Studientypen mal genau anschauen. Nun ist aber Schluss. Ich hoffe, ich konnte ein wenig Licht reinbringen in die Dunkelheit der evidenbasierten Medizin und ihrer gesundheitspolitischen Anwendung.

Stand: 19.12.21

Zurück zur Startseite